Ferons-nous confiance aux robots qui nous entourent ?

Deuxième article sur les changements qui affectent le secteur de l’automobile à la lueur de la récente «affaire Volkswagen». En entrant plus profondément dans l’univers des technologies, la voiture rencontre des problèmes qui dépassent largement le cadre de la mobilité. Ils s’inscrivent dorénavant dans ceux du rapport de l’homme à la machine, soulevant des cas complexes de responsabilité, éthique et confiance dans les organisations qui les conçoivent.

15marches est une agence d’innovation

Découvrez nos offres

Dans le premier article « le logiciel dévore Volkswagen », nous insistions sur l’anachronisme de la tricherie du constructeur allemand à une époque où les consommateurs recherchent une mobilité plus propre, connectée et partagée. La deuxième partie se veut plus prospective : elle interroge notre relation actuelle et future avec les logiciels, algorithmes et interfaces qui s’insèrent dans nos vies.

1. Accepterez-vous de lâcher le volant ?

Google n’est plus seul : pas moins de 25 entreprises travaillent au développement de véhicules autonomes. Comme souvent en matière de nouvelles technologies, il n’en faut pas plus pour que les analystes rivalisent d’effets d’annonce sur l’adoption massive des self-driving cars dans les prochaines années :

Plus circonspects, les chercheurs de la très sérieuse Carnegie Mellon University ont testé dans quelles conditions les humains accepteraient de se laisser conduire par des robots. La conclusion est très instructive : les humains ne font pas autant confiance aux automates qu’ils se font confiance à eux-mêmes. “Un robot peut vous sauver la vie, si vous êtes assez intelligent pour le laisser le faire”. Lorsque nous travaillons avec un robot, nous restons sur nos gardes : 81% des humains préfèrent “reprendre le manche”, même si ils savent qu’ils feront plus d’erreurs que le robot. « En d’autres termes, même confrontés à la preuve de leur propre infériorité, les humains résistent à l’aide des robots. Lorsque les robots font des choses que nous ne comprenons pas, comme détecter des obstacles que nous ne voyons pas ou suivre des règles que nous ne connaissons pas, nous perdons confiance et « reprenons le manche », même lorsque la machine a raison ». C’est pourquoi les chercheurs ont décidé d’introduire un peu d’humilité dans le système, en concevant des machines qui « reconnaissent leurs propres erreurs ». Concrètement, peu avant de commettre une erreur (programmée), le robot indiquait par un voyant de couleurs son « doute » sur sa propre performance, par exemple un problème de capteurs ou un choix impossible entre deux options. Le résultat : les participants bénéficiant de cette nouvelle fonctionnalité ont globalement plus souvent « lâché le manche » que les autres, et non le contraire. Ils ont globalement plus fait confiance à la machine que l’échantillon qui n’a pas bénéficié de cette fonctionnalité. « Nous avons besoin de machines qui reconnaissent leur propre vulnérabilité. Les robots doivent nous dire quand ils peuvent se tromper, mais aussi expliquer pourquoi : par exemple les conditions dans lesquelles leurs capteurs sont moins fiables ou les situations dans lesquelles leurs modèles de prises de décision sont pris à défaut». Découvrez le détail de l’expérience ici.

2. Ce robot a été programmé pour vous tuer

Vous entrez dans votre voiture. Clé de contact. Débrayage. Point mort. Contact. Première vitesse. Rétro, cligno. Un scooter passe. Vous sortez de votre place, redressez, puis passez la seconde. Premier carrefour. Une voiture arrive. Vous avez le temps de passer, le feu est vert au loin. Troisième vitesse. Votre esprit est déjà au boulot. Partir en retard n’est jamais une bonne manière de commencer la semaine. Vous arrivez à l’approche du carrefour, quand soudain une camionnette déboîte de sa file de stationnement à quelques mètres devant vous. Un coup de volant et à peine le temps de voir le cycliste en sens inverse. Trop tard : il s’écrase sur votre pare-brise. Votre premier réflexe a été de braquer pour éviter le véhicule devant vous. Le cycliste en sens inverse n’a juste pas eu de chance de vous croiser à ce moment précis. Cet accident était difficilement évitable, comme beaucoup de ceux qui causent 1,2 million de morts chaque année dans le monde. Qu’aurait fait un véhicule autonome à votre place ?

« Alors que les conducteurs humains ne peuvent que réagir instinctivement à un événement soudain, une voiture autonome est pilotée par un logiciel, qui scanne en permanence son environnement grâce à des capteurs capables de réaliser de multiples calculs avant même que l’on soit conscient du danger. Ils peuvent faire des choix en une fraction de seconde pour optimiser les accidents, c’est à dire, pour minimiser les dégâts. Mais les logiciels ont besoin d’être programmé et ce n’est pas une tâche facile dans certains cas. ». Cet article de Wired soulève une question qui va bien au-delà de l’informatique. Au nom de l’optimisation des accidents, un bon algorithme sera programmé pour heurter le véhicule qui a le plus de chance de survie, ou pour éviter celui qui a le moins de chance. Dans votre cas, il choisira sûrement de heurter la camionnette afin d’éviter le vélo. Dans un autre cas, il heurtera un cycliste casqué et épargnera un cycliste non casqué. Et le journaliste de poser cette question cruciale : qui devra prendre le leadership de ce type d’analyse – et les décisions de programmation qui en découleront : les constructeurs, leurs fournisseurs de logiciel, les législateurs, les philosophes ? On le voit, nous sommes bien loin de la bidouille de carburateurs comme dans l’affaire Volkswagen ! Les questions posées ici sont déjà une réalité par exemple pour les militaires. « Programmer une voiture pour heurter une personne plutôt qu’une autre ressemble horriblement aux targeting algorithms développés pour les armes militaires (lire ici). Et cela entraîne la voiture autonome sur de dangereux chemins légaux et moraux » conclut l’article.

En dehors de la conduite, l’automobile est également sujette à des questions plus triviales. À mesure que nos informations, relations et décisions sont assistées par des logiciels se posent des questions de liberté et de transparence qui ne peuvent être laissés entre les seules mains de fabricants, aussi vertueux soient-ils.

3. Ces logiciels qui nous gouvernent

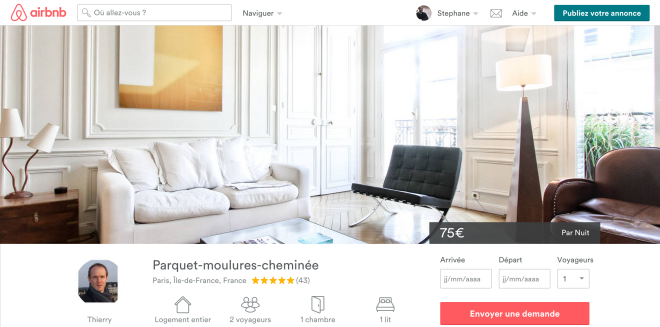

De Google Now à Yelp en passant par Siri, les logiciels prennent déjà beaucoup « d’initiatives » pour nous conseiller le meilleur moyen de nous déplacer, trouver un restaurant, rejoindre nos amis,… Demain ces solutions seront intégrées nativement dans nos véhicules, nos maisons, nos environnements de travail… faisant de nos vies une continuité « sous contrôle ». Dans Datanomics (FYP, 2015), Simon Chignard et Louis-David Benayer nous aident à comprendre ces enjeux : « Après l’ouverture et la transparence des données, c’est bien celles des algorithmes qui font aujourd’hui débat. (…) La société Airbnb a construit un système permettant aux utilisateurs qui mettent leur appartement en location d’estimer le prix de la nuitée. Cet algorithme se nourrit des données de la plateforme : la nature du bien, le prix des autres biens dans le secteur, l’élasticité constatée entre la demande et les prix, la saisonnalité, etc. Lors des premières expérimentations de cet algorithme prédictif, ceux qui l’utilisaient avaient trois fois plus de chance de louer leur bien que les autres. Or cet algorithme est d’abord conçu pour satisfaire les objectifs de la plateforme et en premier lieu la maximisation des chances de location. La rémunération d’Airbnb est liée au volume de transaction et non directement à leur montant. Les recommandations de la plateforme ne sont donc pas nécessairement optimales pour les loueurs. En fixant un prix supérieur, ils pourraient disposer d’un revenu comparable avec moins de nuitées ».

Tromper notre libre-arbitre ne suffit pas. Les logiciels veulent capter notre attention, la conserver et influencer nos comportements. Ils sont conçus pour nous rendre addict, et y arrivent plutôt bien. L’anthropologue Natasha Dow Schüll a mené en 2012 une passionnante recherche sur la manière dont les designers influencent les comportements des joueurs à Las Vegas, de la courbure des voies d’accès à celle de l’arête des tapis de sol, en passant par le fonctionnement des machines à sous et les règles des jeux qu’elles proposent. Pas besoin de truquer les machines à sous : chaque détail contribue à créer une expérience quasi-hypnotique dans laquelle le joueur n’a jamais l’impression de perdre. Il est encouragé en cela par des « boucles ludiques » qui empruntent autant au jeu vidéo qu’aux sites pornos pour la « haute fréquence » à laquelle le joueur est incité à zapper jusqu’à perdre le sens de ce que fait sa propre main. Étonné(e) ? Regardez comment vous vous servez de votre smartphone.

La professeure du MIT conclut son étude en prédisant que l’avenir réservera des surprises de taille : alors qu’aujourd’hui les campagnes publiques de prévention des addictions visent à culpabiliser la victime (pensez aux jeux en lignes), demain la responsabilité des designers de ces jeux sera peut-être mise en évidence, ouvrant la porte à des procès retentissants. Écoutez-la dans Place de la Toile

Encore une fois, je me répète, la tricherie de Volkswagen n’est qu’un amuse-bouche au regard de ce qui attend les constructeurs demain en matière de risque et de responsabilité autour du logiciel. Alors, que faire pour limiter ces risques et surtout, protéger le consommateur ?

4. Mettez un Snowden dans votre moteur

Qui seront les lanceurs d’alerte de l’ère numérique ?

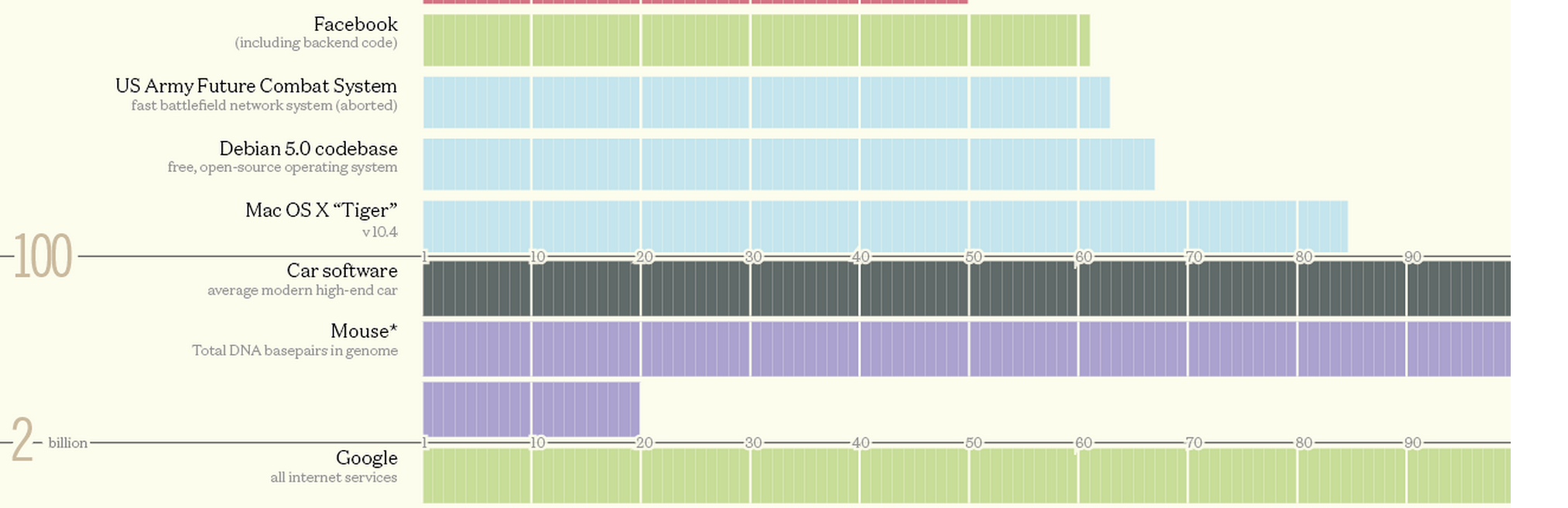

En 2013 le très sérieux blog Privatics de l’INRIA (organisme public de recherche sur le numérique) fit une découverte inattendue en étudiant le code source de l’application RATP : l’application transmettait à une régie publicitaire des informations très détaillées sur le profil et les comportements de ses utilisateurs, à leur insu et au mépris de la politique de confidentialité affichée ! L’INRIA avait détaillé dans deux articles les multiples manquements et émis des recommandations à destination des développeurs. Sans doute gênée, la RATP avait alors « précisé » suite à cette découverte qu’il s’agissait d’un module « à l’étude » chez la régie publicitaire, « implémenté à tort », et s’était engagée à mettre fin à ces pratiques. Même si Apple et Google ne sont pas réputés pour l’ouverture de leurs solutions (surtout le premier), il a quand même été possible à quelques ingénieurs motivés et compétents de réveler les manquements de la RATP. S’agissant de solutions plus élaborées, la difficulté est d’une autre taille. À titre d’exemple, une application sur iOS représente souvent moins de 50 000 lignes de code, là où une voiture moderne en nécessite 10 millions et une voiture autonome…100 millions ! Deux mille fois plus. Impossible par conséquent d’y trouver un « logiciel caché », même si on y avait accès.

L’infographie à voir ici

Mais que fait la police ?

Et l’État dans tout ça ? Hubert Guillaud nous fournit quelques pistes dans un article d’Internetactu :

“A mesure que nos vies s’informatisent, nous devenons toujours plus vulnérables à la fraude numérique. Pour Bart Selman, spécialiste de l’Intelligence artificielle à l’université de Cornell, d’autres domaines sont encore à risque, comme le monde médical, l’assurance ou la finance, où le secret et la confidentialité des contraintes rendent encore plus difficile la détection des actes répréhensibles. Pour lui, nous devons exiger de nouvelles règles pour contraindre les ingénieurs logiciels à être responsables de leurs actes, explique-t-il en invitant à introduire des procédures éthiques pour que les algorithmes rendent compte de leurs effets. “A mesure que les objets du quotidien deviennent plus intelligents et plus connectés, nous allons avoir besoin de nous inquiéter de manquements de plus en plus nuancés à la loi”, rappelle encore Calo. (…) En attendant que le régulateur comprenne la nécessité de favoriser les contrôles, de renforcer les contre-pouvoirs, indépendance et rétroingénierie, sont les deux leviers qui demeurent à notre disposition.”

Dans Le Monde, le journaliste Martin Untersinger rappelait que « l’EPA (l’organisme gouvernemental à qui l’ONG a signalé la fraude) aurait pu déjouer seule la manœuvre de Volkswagen. Mais pour cela, elle aurait dû s’intéresser non pas aux particules émises, mais à la manière dont le programme équipant les voitures pouvait les moduler. Ce n’est donc plus seulement d’experts chimistes dont l’administration a besoin, mais d’informaticiens. » Encore faudrait-il être capable de lire 100 millions de ligne de code, et que ces lignes soient accessibles.

Ouvrez ouvrez la cage aux données

Les promoteurs de l’open source et des « communs » ont évidemment tiré parti de ce scandale pour avancer les limites intrinsèques du logiciel propriétaire : « nous avons tous appris depuis le 20ème siècle que les ascenseurs devaient être inspectables, et demandé aux constructeurs d’ascenseurs de les rendre facilement inspectables. Si Volkswagen avait su que chaque acheteur de ses modèles avait le droit de lire le code source de chaque logiciel la commandant, ils n’auraient jamais envisagé de tricher, se sachant sûrs d’être pris » écrit David Bollier dans son blog. Les tenants du logiciel propriétaire auront tôt fait de rétorquer qu’en matière de concurrence, révéler son code équivaut à révéler des secrets industriels. C’est pourtant bien plus que cela qu’à fait le constructeur de voitures électriques Tesla. En juin 2014, Elon Musk rend les brevets de Tesla accessibles à tous. Pour lui : « Si une entreprise dépend de ses brevets, c’est qu’elle n’innove pas ou alors qu’elle n’innove pas assez rapidement». Mais tout le monde n’a pas intérêt comme Tesla à diffuser sa technologie pour faciliter son adoption dans un secteur – le véhicule électrique – qui a d’abord besoin de standards pour se développer.

Et si on donnait au consommateur les outils pour choisir ?

Difficile à ce stade de savoir comment protéger le consommateur sans tuer la compétition et l’entreprise. Comme souvent, il semble que donner à chacun le droit de vérifier et comprendre ce qu’il consomme semble la première chose à mettre en œuvre. En clair : donner aux citoyens-consommateurs les moyens de savoir ce qu’ils mangent, respirent et conduisent en toute indépendance. Passer du quantified self au quantified environment en analysant l’effet du second sur le premier. C’est le sens d’initiatives comme OpenFoodFacts, une base de données collaborative qui vous informe sur la composition de près de 40 000 produits alimentaires. Dans le domaine environnemental, la startup Plume Labs vous fournit heure par heure des informations sur la qualité de l’air issues de l’open data dans 150 villes, y ajoutant des conseils sur les comportements à risque (ex. : quand faire du sport ou promener son bébé) et des prévisions basées sur la modélisation de facteurs multiples. Les capteurs « grand public » se multiplient dans la ville, transformant chaque individu en lanceur d’alerte potentiel. Plutôt que de jouer au gendarmes et aux voleurs, donnons-nous les moyens de choisir en testant nous-même la pollution des véhicules que nous utilisons, la toxicité des produits que nous mangeons et la transparence des applis et autres offreurs de solution. Car si l’affaire Volkswagen souligne une faiblesse, voire une hypocrisie, c’est d’abord celle des contrôles mis en place par les pouvoirs publics qui ne sont plus adaptés à l’ère numérique.

Souhaitons que cette crise nous ouvre les yeux sur la nécessité de (re)prendre en main notre environnement, non pas en changeant de voiture, mais en utilisant à bon escient le pouvoir que nous donnent les technologies.

Si vous aimé cet article, vous pouvez le partager

Ne manquez plus un article, abonnez-vous !

15marches est une agence d’innovation

Découvrez nos offres

Découvrez notre newsletter

Suivre Stéphane